人工智能伦理学:问题、策略与未来展望

一、人工智能伦理学基本概念

人工智能伦理学是研究在人工智能开发和实践中可能产生的伦理问题的学科。它涉及如何负责任地使用人工智能技术,以及如何预防潜在的危害和滥用。人工智能伦理学不仅关乎技术本身,更关乎人类社会、道德和法律责任等复杂议题。

二、人工智能伦理学问题

1. 数据隐私和安全:人工智能技术需要大量数据进行训练和优化,这引发了关于数据隐私和安全的问题。如何保证个人数据不被滥用或泄露,以及如何平衡数据利用和保护个人权益,是亟待解决的伦理问题。

2. 偏见和歧视:算法偏见可能导致不公平的结果,例如在招聘、信贷审批或司法判决中。如何确保算法公正性,避免因偏见导致的不公平待遇,是人工智能伦理学的重要议题。

3. 自动化和就业:随着人工智能技术的普及,许多传统职业可能被自动化取代。如何在推动技术发展的同时,减少对就业的影响,避免社会不平等和失业问题,也是人工智能伦理学关注的重点。

4. 人机关系:人工智能技术可能改变人与人之间的关系,例如通过社交机器人进行情感交流或通过智能助理进行决策辅助。如何确保人机关系的道德性和伦理性,避免对人类价值观的冲击,是人工智能伦理学的重要议题。

三、解决人工智能伦理学问题的策略与方法

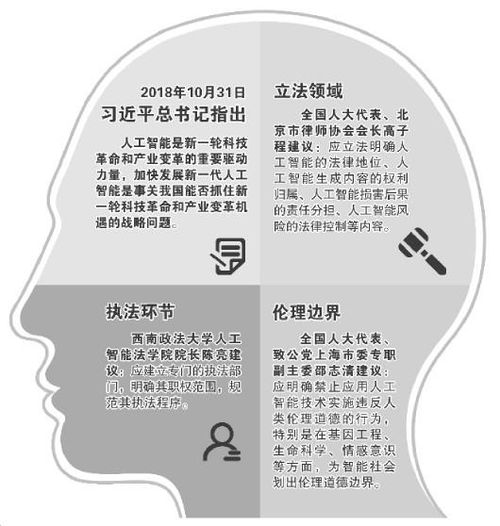

1. 立法监管:通过制定相关法律法规,规范人工智能技术的使用,保护个人隐私和数据安全。同时,对违法使用人工智能的行为进行制裁,维护社会公平与正义。

2. 伦理准则和行业标准:制定人工智能伦理准则和行业标准,引导企业负责任地开发和运用人工智能技术。鼓励行业自律组织建立伦理规范,对违反伦理规范的企业进行惩罚。

3. 透明度和可解释性:提高算法的透明度和可解释性,确保算法决策过程可追溯且公正。这有助于提高公众对算法的信任,并预防潜在的歧视和不公平结果。

4. 教育和培训:加强人工智能伦理学的教育和培训,提高从业人员的道德意识和伦理素养。通过培养具备专业知识和管理能力的人才,预防潜在的伦理问题。

5. 公众参与和社会监督:鼓励公众参与人工智能技术的讨论和决策过程,提高公众的知情权和参与权。同时,加强社会对人工智能技术的监督,确保技术的合理使用和发展方向的正确性。

四、未来展望与结论

随着人工智能技术的快速发展,我们面临着诸多伦理挑战。只有通过深入研究和实践探索,才能找到解决这些问题的有效途径。同时,我们需要不断加强国际合作和交流,共同应对全球性的挑战。在推动人工智能技术发展的同时,我们应始终牢记伦理原则,确保技术的道德性和伦理性。只有这样,我们才能实现人工智能技术的可持续发展,为人类带来更多的福祉和价值。