人工智能伦理学问题研究

1. 引言

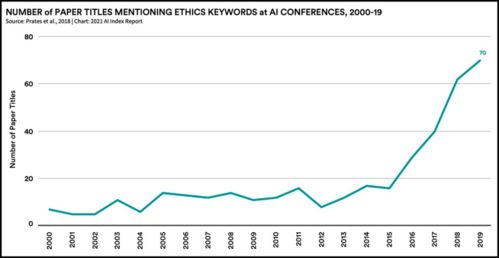

随着人工智能(AI)的快速发展,其在各个领域的应用越来越广泛。随之而来的是一系列伦理学问题。人工智能伦理学作为一门新兴学科,旨在研究如何解决这些问题,确保人工智能技术的合理、公正和道德的使用。

2. 人工智能伦理学基本概念

2.1 人工智能伦理学的定义

人工智能伦理学是一门研究如何正确使用和发展人工智能技术的学科,旨在确保人工智能系统在设计、开发和使用过程中符合人类的道德价值观和伦理原则。

2.2 人工智能伦理学的目标

人工智能伦理学的目标包括:

确保人工智能系统的设计、开发和使用过程中遵循公平、公正和透明的原则; 防止和解决人工智能系统可能带来的歧视、压迫和不公等问题; 促进人工智能与人类价值观的和谐共存。

2.3 人工智能伦理学的研究内容

人工智能伦理学的研究内容主要包括:

算法公平性:研究如何避免算法决策可能带来的偏见和歧视; 数据隐私:探讨如何在数据收集、存储和使用过程中保护个人隐私; 机器人权利:讨论机器人作为人工智能系统的代表,是否应该享有权利和义务; 机器伦理:研究机器行为和决策是否应遵循道德原则和伦理规范。

3. 人工智能伦理学问题分析

3.1 算法歧视

算法歧视是指在人工智能系统的设计和应用中,由于算法的偏见或数据的不完整性等原因,导致系统对某些人群的不公平对待。例如,某些贷款审批算法可能因为数据集的偏差而歧视某些人群。

3.2 数据隐私泄露

随着大数据和机器学习的广泛应用,数据隐私泄露问题日益严重。一些组织或个人可能会收集、存储和使用大量个人信息,如身份信息、健康记录等,这些信息可能被泄露或滥用。

3.3 机器人权利问题

随着机器人技术的不断发展,机器人逐渐成为人类的伴侣和工作伙伴。机器人权利的问题却一直存在争议。例如,机器人是否应该享有与人类同等的权利和义务?机器人是否应该具有自主意识和情感?这些问题需要我们深入探讨。

3.4 机器伦理问题

随着机器智能的发展,机器的行为和决策越来越复杂。例如,自动驾驶汽车在面临紧急情况时应该如何选择?机器在做出决策时是否应该遵循道德原则和伦理规范?这些问题需要我们深入研究。

4. 解决人工智能伦理学问题的策略

4.1 算法公平性的改善

为了解决算法歧视问题,我们可以采取以下措施:

在算法设计阶段,尽可能使用公正、无偏见的数据集; 采用公平性评估工具,对算法的性能进行评估和调整; 加强监管,确保算法设计和应用中遵循公平、公正和透明的原则。